Il Tredicesimo Cavaliere 2.0

CI SIAMO!!!

Il Tredicesimo cavaliere si rinnova e lo fa con gran stile. La nuova versione: Il Tredicesimo Cavaliere 2.0 raggiungibile seguendo questo link.

Ci siamo quasi…

A breve sarà on-line il nuovo blog: “IL TREDICESIMO CAVALIERE 2.0“, che si propone di stupire i fedelissimi e di coinvolgere sempre più appassionati ed esperti di scienze delle spazio e fantascienza.

Il Team di autori e in particolar modo il responsabile supremo, sua eccellenza Roberto Flaibani, stanno lavorando a ritmi serratissimi con l’intento di creare un ambiente accogliente, che riesca a coinvolgere e a nutrire la sete di conoscenza verso ciò che ci circonda.

Completamente rinnovato in grafica e funzionalità, ma sulla consolidata linea guida del suo predecessore, Il Tredicesimo Cavaliere 2.0 vi invita a lasciare commenti, idee e suggerimenti al fine di prepararsi al meglio al suo lancio.

Lenti gravitazionali nel Sistema Solare

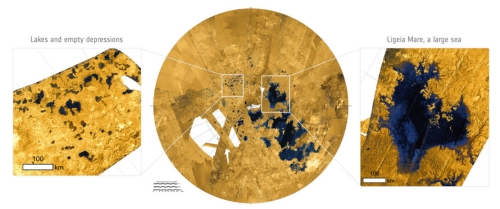

Immagine: la fascia completa delle sfere focali comprese fra 550 e 17.000 UA dal Sole, creata dall’effetto di lente gravitazionale del Sole e di ciascun pianeta, mostrata in scala. La scoperta di questa fascia di sfere focali è il principale risultato esposto in questo lavoro, insieme al calcolo dei relativi guadagni di antenna. Fonte: C. Maccone.

La prima dimostrazione sperimentale della Teoria della Relatività Generale fu eseguita da Arthur Eddington nel 1919, quando riuscì a misurare gli effetti del campo o meglio del pozzo gravitazionale del Sole sulla luce delle stelle ad esso vicine. La massa del Sole, infatti, genera una distorsione del tessuto dello spaziotempo in grado di deflettere le onde elettromagnetiche provenienti da una “sorgente”astronomica di qualsiasi tipo (pianeti extra-solari, stelle, galassie, o altro), e farle convergere in un punto detto “fuoco”, dove l’informazione da esse veicolata risulta intensificata, amplificata, ingrandita. Per le evidenti analogie con le lenti ottiche, questo fenomeno è stato chiamato “lente gravitazionale”. Il fuoco del “sole nudo”, così chiamato perché la sua posizione è stata calcolata senza tener conto di nessun effetto di distorsione o attenuazione del segnale sorgente, si trova ben addentro alla Nube di Oort alla bella distanza di 550 <UA>.

Dato che abbiamo parlato del fuoco gravitazionale del Sole, è interessante riflettere sulla storia di questo studio. Il pensiero di Albert Einstein sulle lenti gravitazionali in astronomia fu affrontato esplicitamente in un documento del 1936, ma per le formule matematiche alla base del fenomeno su vasta scala si dovette aspettare fino al 1964, quando Sydney Liebes dell’Università di Stanford lavorò con la lente prodotta da una galassia interposta fra la Terra e una quasar lontana. In questo modo nel 1978 l’astronomo britannico Dennis Walsh ottenne la prima “immagine” di una quasar, seguita l’anno successivo dallo studio di Von Eshleman sulla lente del Sole, comprendente l’idea di inviare un telescopio al fuoco del Sole nudo.

Riflettendo su come utilizzare la lunghezza d’onda di 21 cm Eshleman pensò al SETI, il cui concetto fu poi esposto da Frank Drake nel 1987. Se si ha a portata di mano una buona biblioteca accademica, la sua raccolta del Journal of the British Interplanetary Society del 1994 dovrebbe includere i risultati della Conferenza su Missioni Spaziali e Astrodinamica che Claudio Maccone organizzò due anni dopo. Si pensò quindi al telescopio spaziale FOCAL nell’ambito della missione SETISAIL, anche se il SETI sarebbe stato solo uno dei tanti aspetti delle sue indagini scientifiche.(n.d.e.)

FOCAL oltre le stelle

Per cercare un modo di sfruttare la lente gravitazionale del Sole dobbiamo tenere conto della corona solare, un problema che venne presto affrontato sia da Eshleman (Stanford) sia da Slava Turyshev (JPL). Per evitare le distorsioni della corona bisognerebbe inviare un telescopio non a 550 UA di distanza ma ben più lontano, approfittando del fatto che non abbiamo a che fare con un punto focale ma con una linea focale. A tale proposito riportiamo il pensiero di Claudio Maccone:

“una conseguenza semplice ma molto importante della discussione di cui sopra è che anche tutti i punti su una retta oltre questa distanza focale minima sono dei fuochi, perché i raggi luminosi passanti accanto al Sole a una distanza superiore a quella minima hanno un angolo di deflessione più piccolo e pertanto si uniscono a una distanza ancora maggiore dal Sole.”

Abbiamo quindi la possibilità di spostarci oltre le 550 UA, anzi non abbiamo scelta. La corona solare crea quello che Maccone definisce un “effetto di lente divergente”, che si oppone all’effetto convergente associato a una lente gravitazionale. Parafrasando il documento si può dire che la distanza minima che la sonda FOCAL deve raggiungere è maggiore per le frequenze più basse (delle onde elettromagnetiche che attraversano la corona) e minore per le frequenze più alte. Quindi, a 500 GHz il fuoco si trova a circa 650 UA. A 160 GHz, si trova a 763 UA.

Ma nel caso volessimo realizzare ponti radio interstellari, dovremmo forse limitarci all’utilizzo della lente gravitazionale del Sole e di quelle delle stelle vicine, in realtà anche i pianeti possono essere usati a questo scopo. Nel suo studio del 2011 riguardante quest’idea, pubblicato su Acta Astronautica, Maccone produce le equazioni necessarie, notando che il rapporto fra il quadrato del raggio di un pianeta e la sua massa ci permette di calcolare la distanza che una sonda deve raggiungere per poter sfruttare la lente del pianeta stesso. Di conseguenza abbiamo definito il concetto di “sfera focale” di un pianeta.

La lente si sposta nella Nube di Oort .

L’illustrazione a inizio articolo contiene delle sorprese. Ci aspetteremmo Giove in cima all’elenco di lenti planetarie e, in effetti, la sua sfera focale è la prima fuori dal Sole a 6100 UA. È un numero utile da ricordare, perché potremmo scoprire che gli effetti della corona solare sono insormontabili per la produzione delle immagini necessarie. In tal caso, dovremmo usare una posizione a metà strada verso la Nube di Oort interna.

Dato che ha un rapporto elevato fra quadrato del raggio e massa, dopo Giove troviamo Nettuno a 13.525 UA. La sfera focale di Saturno si trova a 14.425 UA, dopodiché troviamo quella della Terra a 15.375 UA. Il nostro pianeta è un miglior candidato di Urano come lente perché è il corpo con la maggiore densità (rapporto fra massa e volume) nel Sistema Solare. Maccone lo sottolinea particolarmente perché conosciamo la superficie e l’atmosfera della Terra meglio di quelle di qualsiasi altro pianeta. Una missione FOCAL utilizzante la Terra come lente partirebbe in netto vantaggio per aggiustare l’immagine distorta di un oggetto distante.

Come potremmo sfruttare queste sfere focali planetarie, che nel caso di Venere si estendono fino a 17.000 UA? Partendo dal Sistema Solare una sonda veloce potrebbe esaminarle una per una, iniziando le osservazioni al calare degli effetti della corona solare. Sottolineando che una sonda diretta ad Alpha Centauri attraverserebbe tutte queste sfere focali, Maccone riflette sugli eventuali risultati:

“Innanzitutto, anche se il Sole è immobile nel quadro di riferimento eliocentrico del Sistema Solare, i pianeti invece si muovono. Ciò significa che attraversano una certa area del cielo visto dalla sonda, la quale potrebbe trarre vantaggio da questa specie di lente di ingrandimento semovente. Quanti sono i pianeti extrasolari che ricadrebbero all’interno di questa lente? Ovviamente al momento non lo sappiamo, ma gli oltre 400 esopianeti scoperti finora [il documento risale al 2011] promettono bene per il rilevamento di molti altri esopianeti da parte di una sonda adeguatamente equipaggiata, che percorra la distanza compresa fra 550 e 17.000 UA e che usi le lenti gravitazionali dei pianeti.”

Tali scoperte sarebbero del tutto serendipiche, a dir poco, dato che la nostra missione per Alpha Centauri in uscita dal Sistema Solare vedrebbe solo ciò che si troverebbe in linea con il pianeta studiato. Il fatto di avere Giove a 6.100 UA e la Terra a 15.375 AU ci offre dei bersagli utili per sperimentare le tecnologie che ci serviranno per ricavare delle immagini dall’incontro con una sfera focale. Uno dei grossi punti interrogativi della missione Breakthrough Starshot è la costruzione e l’utilizzo dei laser in fase. Ma se verranno realizzati e potremo raggiungere velocità pari a una significativa frazione della velocità della luce, missioni dedicate all’esplorazione delle lenti planetarie sarebbero fattibili.

Chiaramente è il Sole la nostra prima opzione come lente gravitazionale, non solo per la relativa prossimità del suo punto focale minimo (550 UA), ma perché il guadagno effettivo della sua lente è più alto di quello della lente di Giove e molto più elevato di quello della lente della Terra. Maccone calcola i valori numerici del guadagno dalla riga dell’idrogeno fino al picco CMB a 160 GHz, valutando ognuno di essi per la lente gravitazionale del Sole oltre che per le sfere focali dei vari pianeti. Se vogliamo lavorare con il potenziale delle lenti planetarie, abbiamo bisogno di notevoli progressi nelle tecnologie delle antenne e dell’imaging, al fine di leggere le deboli firme inviate dai pianeti.

Il documento è: Maccone, New Belt Beyond Kuiper’s: A Belt of Focal Spheres Between 550 and 17,000 AU for SETI and Science, Acta Astronautica Vol. 69, Nn. 11-12 (Dicembre 2011), pp. 939-948 (estratto).

traduzione di FAUSTO MESCOLINI

editing ROBERTO FLAIBANI

Anche i computer hanno un’anima ?

“Non parlo male del mio computer, temo che si vendichi”

Fausto Gianfranceschi

Abbiamo la tendenza, sicuramente per farle più “nostre”, a umanizzare le cose, soprattutto le macchine, quali oggetti utili, di lavoro e di divertimento: ad esempio, diamo un nome alle barche, magari anche alle automobili e agli aeroplani. Spesso alcuni specialisti ritengono qualcosa di strettamente personale gli strumenti del proprio lavoro, una specie di prolungamento di se stessi, come in realtà sotto un certo aspetto lo sono: dalla zappa del contadino, allo scalpello e alla pialla del falegname, ma anche la penna dello scrittore, il bisturi del chirurgo. Tutti sono prolungamenti artificiali di qualcosa di naturale: la mano, il braccio, il piede, in ultimo il cervello. I guerrieri dell’antichità, i cavalieri del medioevo davano un nome alla propria spada: non solo era il prolungamento del proprio braccio, ma del proprio Io: aveva un nome e anche un’anima… La spada veniva sepolta con il guerriero morto, la spada del re veniva spezzata. Durlindana ed Excalibur sono entrate nella storia e nell’immaginario collettivo, per non parlare delle spade degli eroi del Signore degli Anelli, da Glamdring la spada di Gandalf a Pungolo la spada di Frodo a Anduril la spada di Aragorn.

Oggi uno strumento di lavoro diffusissimo e universale ad appena una quarantina d’anni dal suo lancio commerciale (il Commodore PET 2001 nel 1975) è il computer personale, quello che una volta si chiamava il “cervello elettronico”, o anche “calcolatore elettronico”, termini che non usa più nessuno. Ma, proprio da questa definizione si capisce come si tratti di uno strumento di lavoro che maggiormente si avvicina all’essere umano, appunto per la sua capacità logica di elaborare dati, informazioni, di scrivere, di disegnare e di fare un numero incalcolabile ormai di funzioni. E proprio per questo il computer risulta ormai la più umanizzata delle macchine.

Sin dall’inizio si è usata nei suoi confronti una terminologia umanizzante: i computer si ammalano, i computer vengono infettati, li colpiscono dei virus, dai bachi (bug), devono essere curati, sono soggetti a periodiche epidemie, a veri e propri contagi diffusi in tutto il mondo eccetera eccetera. Non essendo il computer passivo come la televisione, ma attivo (risponde ad esempio per scritto e oggi anche in voce anche perché ormai gli puoi impartire ordini vocali e dettare testi parlandogli), i suoi utenti si rivolgono a lui personalizzandolo: ci dialogano, lo blandiscono, lo accusano, inveiscono contro di lui, cercano di non irritarlo. Ma, per umanizzato che sia il computer resta una macchina che, spesso e volentieri, non si smuove, non la si convince, non si riesce a farla ragionare…. Il tecnico cui porto a riparare il mio pc una volta mi disse: “Il computer è una macchina illogica”. E se lo dice lui…. Negli Stati Uniti è diffusa la “sindrome da computer”: lo stress che si accumula di fronte alla ostinazione e alla ostilità della macchina si scarica su di essa: impiegati, dirigenti, soprattutto giornalisti vi si scagliano contro a pugni e calci, a martellate, anche a revolverate…

Ora è stato fatto un ulteriore passo avanti nel modo di considerare sempre più umano il computer, ed è stato fatto in una nazione di civiltà e mentalità diverse da quelle degli Stati Uniti e comunque dell’Occidente. In Giappone il computer che non funziona soprattutto perché infettato da virus, perché sottoposto ad attacchi di pirati informatici (ne avverrebbero come minimo 35mila al mese), non lo si maledice, non lo si prende a calci, non lo si distrugge a martellate, ma lo si porta a far benedire in un tempio shintoista per purificarlo dal “maligno digitale”. E’ accaduto qualche temo fa al tempio Kanda Myojin di Tokyo dove si sono riuniti con i loro computer infestati i professionisti di tecnologia informatica ed i membri dell’associazione dei commercianti di elettronica del quartiere Akihabara della capitale giapponese. E il parallelo che viene in mente subito è l’indemoniato che viene esorcizzato in una chiesa cattolica.

Meno strano di quel che sembri, una logica evoluzione delle cose: noi non portiamo forse a far benedire cani, gatti e cavalli? non portiamo a far benedire le automobili? e non portiamo ad esorcizzare in chiesa gli indemoniati? Il computer, ormai metà macchina metà umano (non si stanno elaborando chip biologici?), viene invaso da entità indesiderate che lo bloccano, lo fanno straparlare, lo fanno impazzire, letteralmente gli fanno dare i numeri: e per non impazzire anche loro, i meno violenti giapponesi lo portano a far benedire, ricorrono all’esorcista informatico… Dalla fantascienza il computer infestato è approdato alla realtà. Quindi, sarebbe necessario che accanto alla consolle, vicino alla tastiera, si cominci a tenere una bottiglietta di acqua santa con relativo aspersorio…

E, una volta scientificamente accertato che anche i computer hanno un’anima (il problema se l’erano posto sia Isaac Asimov che Philip Dick, m anche Cliffotd Simak), forse sarebbe il caso di prendere in considerazione l’ipotesi di “battezzarlo” appena uscito di fabbrica…Ma, ci si potrebbe chiedere, l’anima del pc dove si trova? Nell’hardware o nel software, nella “ferraglia” o nel programma? Un bel problema, quasi filosofico. Sta di fatto, però, che ogni tanto riceviamo nella nostra posta elettronica messaggi di questo tipo: “Ciao! Sono il programma X. Mi occupo della mailing list di Y. Sto lavorando per il mio responsabile che può essere contattato a Z…”. Meditate gente, meditate.

Peraltro. la situazione è diventata reversibile. Il computer si umanizza, l’uomo si computerizza, magari soltanto a partire dal proprio nome. Negli Stati Uniti un certo Jon Blake Cusack di Holland (Michigan) passerà alla storia per aver deciso di chiamare suo figlio “2.0”, come fosse la nuova versione di un programma informatico. Lui, il padre, sarebbe dunque “1.0”, tanto da auspicare che un futuro nipote venga chiamato “3.0”. Questo perché il signor Jon Blake Cusack è “un appassionato di computer e software” ed ha visto il film Novecento di Tornatore e Baricco in cui un ragazzino veniva chiamato, appunto, “Novecento”… Questo americano non solo dà i punti agli stravaganti nomi che s’impongono in Romagna, ma apre una moda al passo coi tempi demenziali che stiamo vivendo. Un esempio atroce di totale spersonalizzazione: nessuno ha infatti ricordato che nelle grandi antiutopie del secolo trascorso, da Noi di Zamjatin a Il mondo nuovo di Huxley, da Antifona di Ayn Rand a 1984 di Orwell, i nomi propri sono accompagnati o sostituiti da una sigla ed un numero allo scopo di far scomparire ogni individualità nell’ambito di una società in cui si applicano integralmente il comunismo o un capitalismo esasperato. Un mondo di macchine umanizzate e di uomini-macchina. Ai lettori che desiderano approfondire l’argomento degli esseri ibridi, metà uomo metà macchina, consigliamo la lettura di “Elogio del Cyborg“.

GIANFRANCO de TURRIS

eso13 – Arrivano i giganti…

La ricerca di una traccia biologica nell’atmosfera di un esopianeta è un obiettivo importante e, come spiega Ignas Snellen, le missioni spaziali non sono l’unico modo di procedere. Professore di astronomia all’Università di Leiden nei Paesi Bassi, il Dott. Ignas Snellen è convinto che le tecnologie come la spettroscopia ad alta dispersione e l’imaging a contrasto elevato siano più efficaci quando utilizzate in grandi osservatorii a terra. Un gruppo di astronomi da lui guidati ha già usato queste tecniche per determinare la velocità di rotazione di Beta Pictoris b, pari a otto ore. Per studiare quelle regioni dello spettro che sono inaccessibili da terra, avremo bisogno di telescopi spaziali attentamente studiati e in sinergia con la nuova generazione di telescopi terrestri giganti, che si prevede entreranno in funzione negli anni ‘20 del 2000. (Paul Gilster) A seguire l’articolo del dott. Snellen.

Mentre ero profondamente impegnato nel progetto del mio dottorato di ricerca, studiando i centri attivi di galassie lontane, in un campo molto diverso dell’astronomia si stava compiendo una vera rivoluzione scientifica. A metà degli anni ‘90 si stavano infatti scoprendo i primi pianeti orbitanti intorno a stelle diverse dal nostro Sole. Per alcuni anni riuscii a ignorare queste scoperte. Favorito dalla mia ignoranza in materia, mi univo ai molti scettici che criticavano questi primi risultati. Risultati con i quali invece si dovette presto fare i conti. Quando venne trovato il primo pianeta in transito, seguito poco dopo dal rilevamento della sua atmosfera, cambiai radicalmente campo di ricerca e mi gettai, come molti altri, sugli esopianeti. Dopo oltre un decennio quella rivoluzione è ancora in corso.

DARWIN, TPF e SIM

Negli ultimi venticinque anni non tutte le imprese scientifiche hanno avuto successo. Subito dopo le prime scoperte degli esopianeti sono stati profusi enormi sforzi nella progettazione (e nella ricerca dell’appoggio politico) di una sonda che possa rilevare i potenziali gas marcatori biologici nelle atmosfere dei sistemi planetari vicini. Gli astronomi europei si stavano concentrando su DARWIN. L’idea base della missione prevedeva 4 o 5 sonde spaziali dotate di telescopi con tecnologia di imaging ad alta risoluzione utilizzante l’interferometria ad annullamento. La luce stellare raccolta sarebbe stata combinata in modo tale da annullare la luce in asse, ma lasciando intatta la potenziale luce del pianeta fuori asse. Dopo una serie di studi lunghi oltre un decennio, nel 2007 l’ESA interruppe lo sviluppo di DARWIN, per l’eccessiva difficoltà. Nello stesso periodo furono proposte alla NASA varie versioni del Terrestrial Planet Finder (TPF), compreso un interferometro ad annullamento e un coronografo. Quest’ultimo usa delle ottiche appositamente studiate per ridurre la luce stellare, lasciando passare quella eventuale dei pianeti. Anche questi progetti furono in seguito annullati. Indubbiamente una battuta d’arresto anche peggiore ha interessato la Space Interferometry Mission (SIM), che doveva cercare i pianeti di massa simile alla Terra nelle zone abitabili delle stelle vicine usando l’astrometria. Dopo essere stata rimandata più volte, la missione fu infine annullata nel 2010.

Quanto dovremmo essere pessimisti?

Per questi progetti sono state spese enormi quantità di tempo ed energia dei ricercatori, oltre a milioni di dollari e di euro. È un vero peccato, considerando tutti gli altri interessanti progetti alternativi che avrebbero potuto essere finanziati. Dovremmo porci degli obiettivi più realistici e imparare dalle missioni di successo, come Kepler della NASA, che fu concepita e sviluppata nello stesso periodo. Un aspetto fondamentale dell’adozione di Kepler da parte della NASA fu la dimostrazione, tramite gli esperimenti a terra (di Bill Borucki e colleghi), del fatto che la tecnologia era pronta. Una missione viene infatti approvata solo se si ritiene che ne sia garantito il successo. È questo aspetto che ha affossato DARWIN e il TPF ed è lo stesso che mi preoccupa quando penso ai nuovi concetti base di sonde molto intelligenti, come il grande occultatore esterno per la missione New Worlds. Forse non sono abbastanza sognatore. In ogni caso, come insegna Kepler, i tempi d’attesa delle grandi missioni spaziali sono molto lunghi. Ne consegue che per i prossimi 25 anni sarà molto improbabile che venga lanciata una missione spaziale per cercare i gas marcatori biologici nelle atmosfere dei pianeti simili alla Terra. Se sono fortunato riuscirò a vederla prima di morire. Detto questo, la mia idea è: partiamo da terra!

La sfida a terra

La prima prova di vita extraterrestre verrà dal rilevamento dei marcatori biologici: l’assorbimento derivante da quei gas che ci si aspetta di trovare nell’atmosfera di un esopianeta quando sono prodotti da processi biologici. Gli esempi migliori sono costituiti da ossigeno e ozono, come si vede nell’atmosfera terrestre. L’osservazione di questi gas nelle atmosfere degli esopianeti non sarà la prova definitiva della vita extraterrestre, ma di certo un primo passo. Tali osservazioni richiedono una spettrofotometria di alta precisione, molto difficile da eseguire da terra. Innanzitutto, la nostra atmosfera assorbe e disperde la luce. Si tratta di un problema soprattutto per le osservazioni dei pianeti simili alla Terra, perché i loro spettri mostreranno delle bande di assorbimento nelle stesse lunghezze d’onda dell’atmosfera terrestre. Da parte loro, le turbolenze atmosferiche distorcono la luce che raggiunge i telescopi a terra. La luce quindi non forma dei fronti d’onda perfetti, compromettendo le misurazioni di alta precisione. Inoltre, quando gli oggetti vengono osservati a lungo nel corso di una notte, il percorso della loro luce attraverso l’atmosfera cambia, come cambia la luce stellare che entra nello strumento, rendendo la stabilità un grosso problema. Queste sono le ragioni principali per cui molti appassionati degli esopianeti pensavano fosse impossibile sondarne le atmosfere da terra.

(AVVISO: per chi è interessato a un discorso approfondito sulla spettroscopia ad alta dispersione (HDS) e sulla imaging a contrasto elevato (HCI) abbiamo previsto un percorso separato. Chi preferisce una lettura facilitata, può continuare senza tener conto di questo avviso).

Per rilevare le caratteristiche di assorbimento delle atmosfere degli esopianeti è ideale la spettroscopia ad alta dispersione (high dispersion spectroscopy, HDS), vale a dire la separazione di un’onda in componenti dello spettro con diverse lunghezze d’onda. L’HDS raggiunge una precisione di un milionesimo della lunghezza d’onda però richiede telescopi di enormi dimensioni, non trasferibili nello spazio. I telescopi spaziali possono raggiungere solo la media dispersione, al massimo di un millesimo della lunghezza d’onda, comportando quindi tempi di osservazione di gran lunga maggiori. Un altro vantaggio dell’alta dispersione è che è sensibile all’effetto doppler dovuto al moto orbitale di un pianeta, il cui segnale può essere così distinto sia da quello della sua stella sia da quello dell’atmosfera terrestre. Due nuovi strumenti nel telescopio VLT permetteranno di estendere la ricerca anche ai pianeti più freddi e più piccoli.

Mentre con l’HDS si analizza la luce della stella filtrata dall’atmosfera dei pianeti più vicini, quelli più distanti possono essere osservati con l’imaging a contrasto elevato (HCI) (anche in combinazione con la coronografia), che riduce la luce della stella. I migliori risultati si ottengono con la combinazione delle due tecniche.

Arrivano i giganti

Sia gli Stati Uniti sia l’Europa stanno costruendo una nuova generazione di telescopi che possono essere a ragione chiamati giganti. Il Telescopio Gigante Magellano (Giant Magellan Telescope, GMT) consisterà di sei specchi da 8,4 m, equivalenti a un telescopio del diametro di 24,5 m. Il Telescopio da Trenta Metri (Thirty Meter Telescope, TMT) avrà proprio questa dimensione, mentre il Telescopio Europeo Estremamente Grande (European Extremely Large Telescope, E-ELT) sarà quello più ampio con un diametro effettivo di 39 m. Tutti e tre i progetti sono in competizione per essere pienamente operativi intorno al 2025.

In questa partita le dimensioni sono tutto, in particolare per le osservazioni HDS e HDS+HCI. L’HDS trae beneficio dal numero di protoni che si possono raccogliere, proporzionale al quadrato del diametro. Prendendo in considerazione anche altri effetti, l’E-ELT sarà cento volte più sensibile del VLT (in particolare grazie allo strumento della prima luce METIS e a HIRES). Il telescopio ci porterà vicino all’intervallo necessario per cercare l’ossigeno molecolare nelle atmosfere dei pianeti terrestri che transitano vicino alle nane rosse. Se questi sistemi vicini in transito esistono potremo dirci fortunati. Secondo le simulazioni, le stelle più piccole rendono il segnale trasmesso dall’ossigeno molecolare di un pianeta delle dimensioni della Terra simile a quelli del monossido di carbonio, già rilevati nelle atmosfere dei gioviani caldi. È solo che i sistemi saranno molto più tenui di Tau Bootis e pertanto richiederanno dei telescopi molto più grandi. La tecnologia esiste già, ma si tratta di raccogliere fotoni a sufficienza. Se persino i telescopi estremamente grandi dovessero rilevarsi insufficienti, il problema dovrà essere risolto in modo diverso. Le osservazioni HDS delle stelle luminose non richiedono degli specchi di forma precisa, pertanto potrebbero essere possibili disponendo delle serie di raccoglitori di luce a bassa precisione, ma si tratta di un’ipotesi lontana nel futuro.

Ancora più promettenti sono le capacità di imaging a elevato contrasto dei futuri ELT. I telescopi non solo raccolgono più fotoni, ma vedono anche in maniera più nitida. La loro capacità di vedere i pianeti più tenui nel bagliore delle stelle luminose aumenta fino alla quinta potenza all’aumentare delle dimensioni. Ciò rende l’E-ELT 1000 volte più sensibile del VLT. I pianeti rocciosi nelle zone abitabili delle stelle vicine saranno quindi a portata di mano. Anche in questo caso le simulazioni indicano la possibilità di rilevare emissioni termiche intorno alle stelle più vicine, mentre HDS+HCI nelle lunghezze d’onda ottiche può cercarne lo spettro di riflettanza, magari includendo le firme dell’ossigeno molecolare.

Missioni spaziali realistiche

Qualsiasi cosa accada con la ricerca degli esopianeti dallo spazio, i telescopi a terra si faranno strada nella caratterizzazione dei pianeti simili al nostro. Ciò non toglie la necessità delle missioni spaziali. Innanzitutto non ho reso giustizia ai dati fantastici e rivoluzionari che ci fornirà il JWST. Poi, una serie di missioni dedicate ai transiti, la TESS della NASA (che verrà lanciata nel 2017) e le CHEOPS e PLATO dell’ESA (2018 e 2024), scopriranno tutti i sistemi planetari vicini in transito, un prerequisito fondamentale per gran parte di quanto fin qui abbiamo discusso.

Soprattutto, le misurazioni da terra non potranno darci un quadro completo delle atmosfere dei pianeti, semplicemente perché gran parte degli spettri non sono da qui accessibili. Pertanto la prova definitiva della vita extraterrestre verrà probabilmente da una missione spaziale del genere di DARWIN o TPF. Il rilevamento da terra dell’acqua nell’atmosfera di un pianeta terrestre aprirebbe delle porte presso i politici, ma della massima importanza sarà il giusto tempismo di tali missioni. Puntando troppo in alto e troppo presto si perderebbe molto tempo e denaro, a spese del progresso nella ricerca degli esopianeti. Sognare è bello, ma senza dimenticare di restare realistici.

Ulteriori letture

Snellen et al. (2013) Astrophysical Journal 764, 182: Finding Extraterrestrial Life Using Ground-based High-dispersion Spectroscopy

Snellen et al. (2014), Nature 509, 63: Fast spin of the young extrasolar planet beta Pictoris b

Snellen et al. (2015), Astronomy & Astrophysics 576, 59: Combining high-dispersion spectroscopy with high contrast imaging: Probing rocky planets around our nearest neighbors .

Titolo originale:”Extraterrestrial Life, The Giants are coming” di Ignas Snellen, pubblicato su Centauri Dreams il 11 settembre 2015

Traduzione e adattamento di FAUSTO MESCOLINI

La mente e le catastrofi

Molti anni fa ho conosciuto un comico tedesco, più un performer che un comico, ma tant’è: era pagato dal comune di Roma per fare il comico/performer/buffone nel quadro delle iniziative dell’Estate Romana.

In sostanza il suo numero consisteva nell’essere vestito in modo molto strano, con un tight verde, un cappello di quelli da Topolino con le orecchie tonde e grandi e due scarpe da clown e la sua azione consisteva nel prendere a colpi di forcone i cocomeri che il pubblico gli tirava. Lo so, sembra folle ma era proprio così: nel Parco del Turismo all’Eur, alle nove di sera, in una piazzuola circondato da 200 persone lui invitava il pubblico a prendere un cocomero da una pila di forse 100, duecento cocomeri e a tirarglielo addosso; e lui cercava di colpirlo con un forcone a tre rebbi, di quelli da pagliaio. Letteralmente.

Era molto strano ma ancora più strano era l’entusiasmo con cui dopo poco il pubblico partecipava, tirando a lui i cocomeri che venivano spaccati al volo e poi tirandosi l’un l’altro addosso i pezzi dei cocomeri. Alla fine c’era una trentina di ragazzi, quasi nessuna ragazza, che si tiravano pezzi di cocomero, sporcandosi, divertendosi da matti, e la cosa è andata avanti per un buon quarto d’ora. Era molto più una performance che non uno spettacolo comico in senso stretto.

Hans era il suo nome ed era amico di amici attori, anche loro presenti per cui dopo la performance mi sono trovato con lui e con i miei amici a parlare del suo lavoro. E lui molto serenamente mi diceva che aveva a che fare con la morte. Sosteneva che la massa della gente oggi, diversamente dal passato, non vede mai la morte, non assiste alla morte reale. Un tempo non era così, la gente moriva per lo più in casa, c’erano le guerre, le morti per malattie, il morto in casa veniva rivestito dai parenti per il funerale e questo fino a tutti gli anni 50 e in campagna anche dopo. Oggi non è così, si muore in ospedale e a rivestire i morti ci pensano i necrofori. Ma la gente sa che la morte c’è, però non la vede, non ha contatto, non il contatto quotidiano di un tempo. La morte è la negazione del consumismo ed il consumismo l’ha rimossa, edulcorata, sterilizzata, nascosta.

Ma la gente, ripeteva Hans, lo sa che la morte c’è, lo sa nel corpo, nell’inconscio, nella propria carne. Per cui quando gli dici “spacca il cocomero” cioè compi un gesto distruttivo e innocuo, lascia galleggiare questo desiderio di distruzione, questa pulsione di morte. Intendiamoci era la sua performance, la sua teoria. Però mi ha colpito e anche molto, soprattutto perché ero rimasto stupito dalla partecipazione di decine e decine di persone a quella foga distruttiva. Ho elaborato un’altra teoria, partendo dal lavoro di Hans.

Il consumismo elimina/nasconde la morte, ma elimina anche le catastrofi. Certo, vediamo poi in televisione in continuazione sparatorie vere e finte, nelle serie televisive come nei documentari delle zone di guerra e ormai Internet ti pernette di vedere perfino le esecuzioni o le torture in diretta se proprio vuoi. Non scherzo: se vuoi, le vedi.

E tutti sotto sotto abbiamo paura delle catastrofi. Perché sappiamo, pensiamo, temiamo che possano accadere. Di solito prendono la forma di eventi naturali, terremoti, maremoti, lo tsunami di qualche anno fa nel Pacifico ha ucciso in un paio di settimane 200.000 persone, per lo più in piccole isole, barchette, sulle coste, ma sempre 200.000. Abbiamo paura delle catastrofi perché sotto sotto pensiamo anche, sappiamo che il benessere nel quale viviamo come occidentali che abitano nel nord del mondo è instabile, forse ingiusto. Non è giusto che noi siamo grassi, moriamo di malattie connesse a eccessi nell’alimentazione, gettiamo milioni di tonnellate di cibo ed il resto del mondo muoia pure di fame, di povertà, di guerre violente. Non va bene e lo sappiamo. Per cui temiamo le catastrofi perché pensiamo di meritarle. Ma le catastrofi non sono così facili.

Certo un meteorite abbastanza grosso cancellerebbe, come ha già fatto, il 75% delle specie di vita sul pianeta, ma io non credo che ce la farebbe con noi. I ghiacci che si sciolgono, mh, cambieranno il clima ma nei porti ne farebbero pochi di danni, ci sposteremmo verso l’interno. Molte di più ne farebbe una vera catastrofe economica. Ecco… tutti hanno paura della crisi economica, dei mercati e delle Borse, ma la crisi veramente rischiosa sarà/sarebbe una crisi sistemica globale, che è possibilissima. Molto più possibile e pericolosa del meteorite o dello sciogliersi dei ghiacci.

Le Borse sono nate per procurare capitali freschi alle industrie e sono immediatamente diventate luoghi di pura speculazione dove la ricchezza si distrugge ma non si crea, e badate, quando si distrugge questo accade per davvero: un crollo del 5% a Tokyo che vuol dire in ipotesi 100 miliardi di dollari sono proprio 100 miliardi di dollari bruciati, distrutti realmente. E quando la borsa riapre e risale non crea il +5% dal nulla, si limita a raccogliere dentro la borsa ricchezza che viene da fuori. Un crollo vero e duraturo del sistema che coinvolgesse anche i debiti pubblici di tutti gli stati che ne hanno sarebbe un crollo spaventoso, una distruzione reale e totale della ricchezza del pianeta. Secondo me morirebbe nel giro di un anno il 90% degli abitanti del pianeta.

Esagero? Mh.

Ne ho già scritto su Il Tredicesimo Cavaliere, troverete l’articolo ed altri riferimenti qui:

Il crollo della Borsa cinese più distruttivo di un asteroide?

Ma il bello è che ho scoperto che la Cina oltre ad essere un paese enorme, con una popolazione non censita che supera i 1300 milioni di abitanti, che possiede oltre il 20% del debito pubblico degli Stati Uniti (situazione pericolosissima per tutti!) è anche il paese dove i miliardari scompaiono!

Cina, il paese dove i finanzieri spariscono nel nulla

Voi capite che se nemmeno una enorme ricchezza ti mette al riparo da scherzi del genere, mh, non c’è da fidarsi molto di nessuno.

MASSIMO MONGAI

ALLA VIA COSI’, YURI !

L’imprenditore e filantropo russo Yuri Milner nemmeno un anno fa aveva messo in subbuglio la comunità astronomica mondiale offrendo tramite la società Breakthrough Listen (consociata della capogruppo Breakthrough Initiatives), un finanziamento di 100 milioni di dollari perché venisse risolto uno degli interrogativi più profondi e complessi che l’uomo si è posto da quando ha cominciato ad esplorare lo Spazio: “Siamo soli nell’Universo? Se non lo siamo, dove sono gli Altri?”.

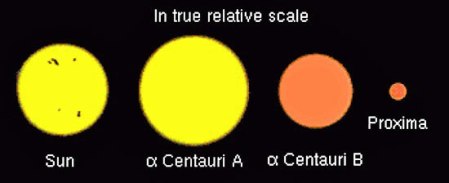

Ora, attraverso un’altra consociata, la Breakthrough Starshot, e con un secondo finanziamento di 100 milioni di dollari, Milner si propone di realizzare uno studio completo per l’attuazione di un volo interstellare fino ad Alfa Centauri della durata di 20 anni, che costerà tra i cinque e i dieci miliardi di dollari. L’iniziativa è stata presentata il 12 aprile a New York ed è stata seguita da un animato brainstorming per addetti ai lavori che si è appena concluso a Palo Alto, in California.

Da brillante stratega qual’è, nella nuova Breakthrough Starshot Milner ha voluto personaggi di prim’ordine: nel consiglio di amministrazione ha confermato Stephen Hawking e cooptato Mark Zuckerberg, fondatore e presidente di Facebook, mentre ha dato l’incarico di direttore a Pete Worden, che per questo ha rinunciato a un analogo incarico presso l’Ames Research Center della NASA. Milner si avvale inoltre di un gruppo di consiglieri di chiara fama, tra i quali da Harvard l’astronomo Avi Loeb, dall’Inghilterra l’Astronomo Reale Martin Rees, da Berkeley il Nobel Saul Perlmutter, da Princeton Freeman Dyson, matematico ed esponente di primo piano del SETI, e Ann Druyan, vedova di Carl Sagan e produttrice della serie televisiva “Cosmos, a Spacetime Odissey”.

Prima di passare a un primo approfondimento, facciamo un po’ di storia. Si era nei giorni a cavallo tra settembre e ottobre 2011 e a Orlando (Florida) si svolgeva il congresso di formazione del 100YSS, il primo movimento di opinione che si proponeva di realizzare il volo interstellare. Era composto di professori e studenti universitari e da una moltitudine colorata di space-enthusiast mobilitati da dozzine di gruppi e associazioni, in un’atmosfera degna di Woodstock. In realtà la convention era frutto dell’intuizione di alcuni pezzi grossi della NASA e sopratutto della DARPA, l’agenzia per la tecnologia avanzata del Pentagono, che aveva fornito all’operazione copertura finanziaria e mediatica, con una formula tutta americana impensabile nel nostro paese. Non è dunque Milner, bensì sono i militari del Pentagono i primi ad avere intuito la potenzialità di mercato e la capacità di innovazione scientifica e tecnologica che un rinnovato interesse allo spazio in questi termini potrebbe destare. Le iniziative di Milner, e degli altri Paperoni che speriamo ne seguano l’esempio, nonostante le differenze rappresentano il logico sviluppo e coronamento della strategia targata DARPA.

Ricordiamo ai lettori che un’informazione sommaria sui particolari tecnici e organizzativi dell’impresa è già stata trasmessa dai media. Ci limiteremo quindi a elencare i punti caldi, fornendo però un’accurata lista di link per chi vuole approfondire.

La tecnologia di base

Le Nanotecnologie e il loro turbinoso sviluppo, sono alla base della proposta della Breakthrough Starshot. Infatti Alpha Centauri, lontana 4,3 anni luce, non sarà raggiunta da una singola astronave, ma da uno sciame di centinaia di nanosonde spaziali di cui esistono già modelli sperimentali chiamati Sprite, ma qui conosciuti come “Starchip”. Trattandosi di una missione di fly-by senza equipaggio, non sono possibili manovre di rientro: dopo aver raggiunto Alpha Centauri, le nanosonde superstiti si perderanno nello spazio.

La navigazione

La tecnica della vela fotonica laser-assistita. Questa tecnica è stata allo studio per molti anni sopratutto ad opera del fisico americano Robert Forward, ma è stata sempre giudicata irrealizzabile fino alla nascita delle nanotecnologie.

Per muoversi, ogni nanosonda sarà abbinata a una vela fotonica di forma quadrata e di 4 metri per lato, costruita con materiali di nuova concezione estremamente leggeri e robusti, e, una volta raggiunta l’orbita terrestre verrà accelerata da un impulso laser lanciato dal suolo in direzione di Alfa Centauri fino alla velocità di 60.000 km/sec, pari al 20% della velocità della luce.

La propulsione

La batteria di laser che farà da propulsore sarà riutilizzabile per varie missioni. Nella sua configurazione principale, quella Starshot, la batteria dovrà essere in grado di emettere almeno una volta al giorno un impulso della potenza di 100 gigawatt e della durata di 2 minuti, e poi ricaricare. Ma si potrebbe usare per spedire sciami di starchip ovunque nel Sistema Solare e verso le stelle più vicine con compiti diversificati. Potrebbe essere utilizzata come arma di Difesa Planetaria , ma purtroppo anche come super-arma in conflitti sulla Terra.

Le telecomunicazioni a lungo raggio

Mantenere telecomunicazioni efficienti tra le nanosonde e la base a terra, probabilmente il Deep Space Network (DSN) della NASA, è indispensabile per il successo della missione. Ma Claudio Maccone, Presidente del Comitato Permanente SETI in seno all’ International Academy of Astronautics di Parigi e autore di profondi studi su questo tema, dice:

Se usiamo il Sole come una lente gravitazionale possiamo mantenere i contatti con le nostre sonde anche a distanze interstellari. Questa è la chiave per esplorare i dintorni del Sistema Solare nei secoli a venire. Anche civiltà aliene potrebbero avere scoperto questo metodo per comunicare a lunga distanza. Se cosi fosse, potremmo entrare a far parte di un vero e proprio Internet interstellare.

Il nostro Sole potrebbe effettivamente rivelarsi il migliore dispositivo possibile per le telecomunicazioni, se la sua gravità potesse essere usata per creare una sorta di radiotelescopio gigante in grado di mandare e ricevere segnali enormemente amplificati. L’astronomo Slava Turyshev del Caltech ha parlato di un “guadagno d’antenna” dell’ordine di 1011 per radiazioni nella gamma ottica. Questa enorme “magnificazione” potrebbe essere sfruttata con radiazioni di qualsiasi lunghezza d’onda, per esempio nella gamma radio. Anzi, si potrebbe creare una rete ancora più potente posizionando delle sonde relais vicino ad altre stelle per formare ponti radio attraverso il grande vuoto interstellare.

Ponti radio “gravitazionali”

Per crearne uno si dovrebbe cominciare piazzando una sonda relais in corrispondenza del fuoco più vicino della lente gravitazionale del Sole, situato alla distanza di 550 Unità Astronomiche (UA) da esso. Quindi all’altro capo del ponte, continuando con l’esempio di Alpha Centauri, deve essere piazzata una seconda sonda relais per potenziare i segnali in entrata e uscita.

Con questi relais in posizione, la percentuale d’errore nelle trasmissioni tra i due capi del ponte crollerebbe da 1 su 2 , a 1 su 2 milioni, pari all’accuratezza raggiunta dal DSN della NASA nell’ambito del Sistema Solare. Sorprendentemente, la potenza di trasmissione richiesta è davvero minima, appena un decimo di milliwatt, come dire svariati ordini di grandezza in meno delle antenne del DSN.

Tuttavia la realizzazione di un sistema radio interstellare basato su lenti gravitazionali darebbe un gran da fare agli ingegneri. Tanto per cominciare, i ripetitori dovrebbero restare precisamente allineati uno rispetto all’altro e ai loro amplificatori stellari anche su distanze estreme, afferma Maccone. Ciò richiederebbe un sistema rivoluzionario di navigazione celeste e orientamento, una sorta di GPS galattico basato sulle pulsar. Ma anche se effettivamente questi ponti radio potrebbero consentirci di tenere i contatti, il limite universale della velocità della luce (e quindi dell’informazione) scoperto da Einstein, implica che il dialogo avrebbe comunque tempi lunghissimi. Data la distanza, una conversazione con una colonia su un ipotetico mondo abitabile (tipo “Avatar”), nel sistema di Alpha Centauri, avrebbe un ciclo domanda–risposta di quasi nove anni.

Attualmente non c’è soluzione al problema del ritardo nelle telecomunicazioni- dice Maccone -Ma la buona notizia è che adesso abbiamo un modo affidabile per comunicare attraverso distanze interstellari.

Concludiamo qui il primo articolo dedicato a Breakthrough Starshot sapendo già che torneremo spesso ad occuparcene.

ROBERTO FLAIBANI

Quando nacque la Fantascienza italiana